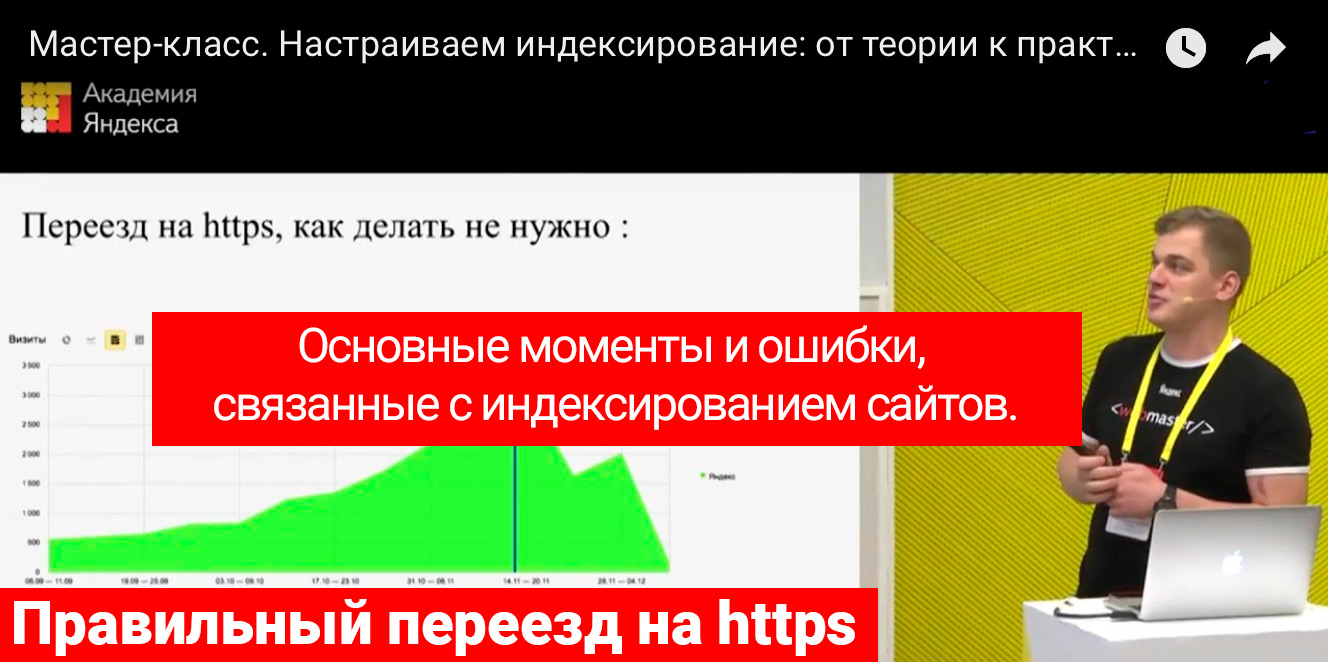

Если бы я знал это чуть раньше... Основные моменты и ошибки, связанные с индексированием сайтов.

Ссылка от Яндекса для участия в седьмой Вебмастерской мне так и не пришла (зачем тогда рассылали приглашения?). Ладно, я не гордый, позже посмотрю в записи - всё равно далеко не все темы были мне интересны. Зато синоптики в этот раз не обманули и у нас, всё-таки, выпал первый снег.

Раз уж настроился в эти выходные научиться чему-то новому, то решил ознакомиться с темами прошлогодней конференции. И надо же как совпало, что один из докладов был прямо по той теме, которая, именно в данный момент, не даёт покоя. Из мастер-класса "Настраиваем индексирование: от теории к практике" удалось из первых рук, от сотрудника Яндекса, подробнее узнать о правильных настройках файла robots.txt, как ускорить индексирование сайта, а также откуда берутся дубли страниц и как предотвратить их появление.

Ну и самое главное, узнал о том в какой последовательности осуществляется переезд на https и зеркала сайта. Печально это признавать, но я снова накосячил при переезде на https, так как 301 редирект на https версию сайта следовало установить только после склейки зеркал. С другой стороны в панели управления хостингом, иного варианта не предлагалось чтобы включить HTTPS... там автоматически включается редирект с http версии на https. Что, в таком случае нужно было прописывать в robots.txt, если https версия сайта еще не работала, а роботу яндекса надо было уже скормить его как главное зеркало? Честно говоря, запутался и ясности в этом вопросе нет. Если кто знает, отпишитесь в комментах, так как данная тема для меня новая.

В любом случае, очень рекомендую данное видео к просмотру, особенно начинающим (к числу которых отношу и себя). Мне же остаётся, только надеяться, что блог, в скором времени, всё-таки восстановится в поисковой выдаче после всех моих экспериментов.

Если считаете статью полезной,

не ленитесь ставить лайки и делиться с друзьями.